在人工智能技术迅猛发展的当下,视觉语言模型展现出了巨大的潜力。今天就为大家分享阿里云精心研发的大规模视觉语言模型 ——Qwen – VL 的一键整合包,让你轻松开启多模态交互的智能之旅。

Qwen – VL 作为阿里云的杰作,属于大规模视觉语言模型(Large Vision Language Model, LVLM)。它拥有极为灵活的输入输出方式,能够以图像、文本、检测框作为输入,以文本和检测框作为输出,为用户提供多样化的交互体验。下面来详细了解一下 Qwen – VL 系列模型的显著特点:

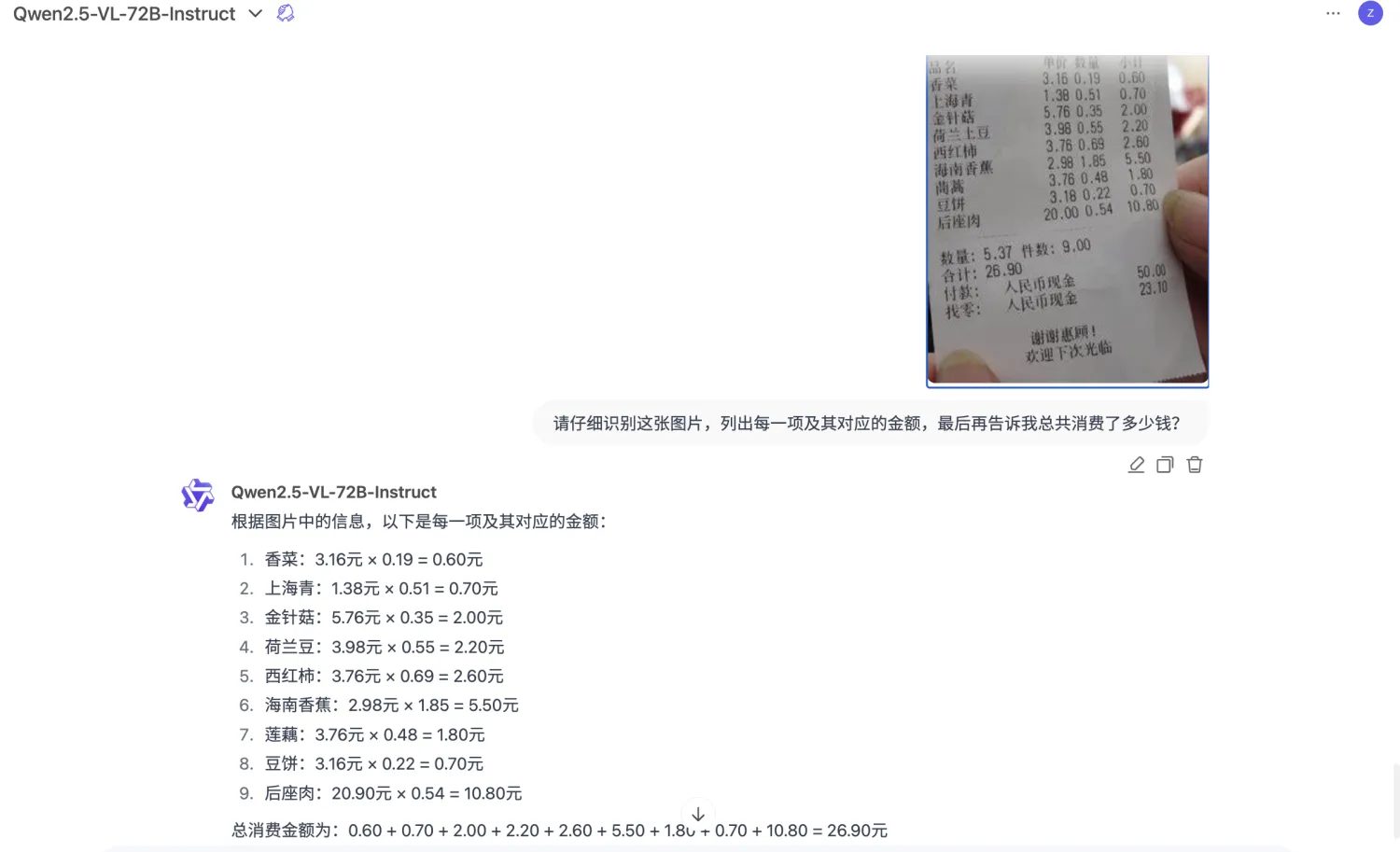

在四大类多模态任务的标准英文测评(Zero – shot Captioning/VQA/DocVQA/Grounding)中,Qwen – VL 表现卓越,在同等通用模型大小的情况下取得了最佳效果。这充分证明了它在多模态处理方面的强大实力,无论是图像描述、视觉问答还是文档问答等任务,都能轻松应对。

Qwen – VL 是一款天然支持英文、中文等多语言对话的模型。它不仅能够理解和生成多种语言的文本,还能端到端支持图片里中英双语的长文本识别。这使得不同语言背景的用户都能无障碍地与模型进行交互,极大地拓展了其应用范围。

该模型支持多图输入和比较,用户可以指定图片进行问答,还能基于多图进行文学创作。想象一下,你可以同时上传多张图片,让模型对它们进行分析、比较,并根据这些图片生成富有创意的故事或描述,为你的创作带来更多的灵感和可能性。

Qwen – VL 是首个支持中文开放域定位的通用模型,它可以通过中文开放域语言表达进行检测框标注。这一特性使得在图像中进行目标定位和标注变得更加便捷和准确,为图像分析和处理提供了有力的支持。

与目前其他开源 LVLM 使用的 224 分辨率不同,Qwen – VL 是首个开源的 448 分辨率的 LVLM 模型。更高的分辨率意味着它能够提升细粒度的文字识别、文档问答和检测框标注能力。它可以更清晰地识别图像中的细节信息,为用户提供更准确、更全面的分析结果。

- 下载并解压软件:访问上述下载链接,将软件压缩包下载到本地。下载完成后,将其解压到一个英文路径下,建议放在非 C 盘的根目录,如 D 盘下面。这样可以避免因路径问题导致的兼容性错误,确保软件能够稳定运行。

- 启动软件:解压完成后,找到 “Qwen – VL.exe” 文件并双击运行。软件启动后,会出现一个网址:http://127.0.0.1:7860。

- 打开操作界面:将这个网址复制到浏览器的地址栏中,按下回车键,即可打开软件的操作界面。在这里,你可以上传图片,与模型进行愉快的对话,体验多模态交互的魅力。

现在就抓住这个机会,点击下载链接,开启 Qwen – VL 的智能之旅,感受多模态图片对话大模型带来的无限可能!

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

评论(0)